香港科大: 突破性方法实现AI多技能高效学习

这项由香港科技大学的王泽东、李思远以及浙江大学的研究团队共同完成的研究发表于2025年7月,论文名为"Rep-MTL: Unleashing the Power of Representation-level Task Saliency for Multi-Task Learning"。感兴趣的读者可以通过论文编号arXiv:2507.21049v1获取完整研究内容。

在人工智能的世界里,有一个让研究者们头疼不已的问题:如何让AI系统像人类一样同时掌握多项技能?这就好比培养一个学生,你希望他既擅长数学,又精通语文,还能在体育方面表现出色。然而现实往往是残酷的——当你试图让AI同时学习多个任务时,它们之间会互相干扰,就像一个学生在学数学时把语文忘了,学语文时又把数学搞混了。

这种现象在学术界被称为"负迁移",简单来说就是不同任务之间的学习会相互冲突,导致整体性能下降。传统的解决方法就像给不同科目安排不同的学习时间和精力分配,或者调整各科目之间的学习顺序,但效果往往不尽如人意。

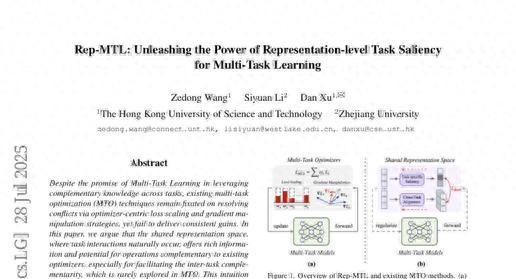

香港科技大学的研究团队提出了一个全新的解决思路。他们认为,与其纠结于如何调配学习时间和精力,不如直接从AI的"大脑"——也就是内部表征空间入手。这就像是直接观察学生大脑中不同知识的存储和连接方式,然后有针对性地进行优化。

研究团队开发的Rep-MTL方法包含两个核心机制。第一个机制叫做"任务特定显著性调节",就像给每个学科保留专属的学习区域,确保数学知识不会被语文知识覆盖。具体来说,这个机制通过分析AI在处理不同任务时哪些"神经元"最活跃,然后用一种叫做熵正则化的数学方法来保持这些活跃模式的独特性。

第二个机制被称为"跨任务显著性对齐",它的作用是找出不同任务之间的共同点,让AI能够充分利用这些共性。这就像发现数学中的逻辑思维能力其实也能帮助学好物理,于是有意识地强化这种跨学科的连接。研究团队使用了对比学习的方法,让AI学会识别哪些知识是可以跨任务共享的,哪些是需要保持独立的。

为了验证这个方法的有效性,研究团队在四个不同的任务组合上进行了大规模实验。这些任务包括室内场景理解(需要AI同时进行语义分割、深度估计和表面法向量预测)、城市场景理解(语义分割和深度估计)以及跨领域图像分类等。实验结果令人惊喜:Rep-MTL不仅在所有测试场景中都取得了最佳性能,而且即使与最基础的等权重方法结合使用,也能显著超越其他复杂的优化策略。

在NYUv2数据集的实验中,Rep-MTL相比基准方法实现了1.70%的任务级性能提升,比之前的最佳方法DB-MTL高出约48%。更重要的是,这种提升是全面的——不管是语义分割的精度、深度估计的准确性,还是表面法向量预测的质量,都得到了显著改善。

研究团队还使用了一种叫做"幂律指数分析"的评估方法来深入理解Rep-MTL的工作机制。这种分析方法可以评估神经网络不同部分的训练质量,就像给学生大脑的不同区域做"体检"。结果显示,使用Rep-MTL训练的模型在共享部分(相当于学生的基础认知能力)展现出更好的跨任务知识整合能力,而在任务特定部分(相当于专业技能区域)则保持了良好的独立性和平衡性。

从计算效率的角度来看,Rep-MTL也表现出色。虽然相比简单的损失函数加权方法需要额外的计算开销,但它比大多数梯度操作方法更加高效。具体来说,Rep-MTL比Nash-MTL快约26%,比FairGrad快约12%,同时还能提供更好的性能表现。

这项研究的创新之处在于跳出了传统的"冲突解决"思维框架。以往的方法主要关注如何减少不同任务之间的冲突,就像在争吵的孩子之间当调解员。而Rep-MTL则更像是一个善于发现和培养孩子潜能的教育专家,既保护每个孩子的独特性,又帮助他们发现彼此之间的共同点,实现互相促进。

研究团队还对方法的稳定性进行了全面测试。他们发现Rep-MTL对超参数的变化相对不敏感,在较宽的参数范围内都能保持稳定的性能表现。这意味着这个方法在实际应用中具有良好的鲁棒性,不需要过度精细的参数调优就能取得不错的效果。

通过详细的消融实验,研究团队证实了两个核心机制的协同效应。单独使用跨任务显著性对齐能够带来一定的性能提升,但效果有限。单独使用任务特定显著性调节也能在一定程度上缓解负迁移问题。只有当两个机制结合使用时,Rep-MTL才能发挥出最大的潜力,实现显著的性能提升。

说到底,这项研究为多任务学习领域带来了全新的视角。它告诉我们,要让AI真正实现"一专多能",关键不在于如何平衡不同任务之间的冲突,而在于如何从AI的内部表征入手,既保护各任务的独特性,又促进它们之间的有益交流。这就像培养一个全面发展的学生,既要让他在各个学科都有所专长,又要让他能够灵活运用跨学科的知识来解决复杂问题。

这个研究成果不仅在学术界具有重要意义,在实际应用中也有广阔的前景。从自动驾驶汽车需要同时进行物体检测、路径规划和决策制定,到智能助手需要同时理解语言、生成回复和执行任务,Rep-MTL的思路都可能带来显著的性能提升。随着AI系统越来越多地被要求同时处理多种任务,这种"内在协调"的方法将变得越来越重要。

当然,这项研究也为后续的工作指明了方向。如何进一步优化表征空间的利用效率,如何在更复杂的任务组合中保持方法的有效性,如何将这种思路扩展到更大规模的模型中,都是值得继续探索的问题。但毫无疑问,Rep-MTL为多任务学习这个重要研究领域开辟了一条充满希望的新道路。对于想要深入了解这项研究细节的读者,可以通过论文编号arXiv:2507.21049v1获取完整的技术报告。

Q&A

Q1:Rep-MTL是什么?它能解决什么问题? A:Rep-MTL是一种让AI同时学习多个任务的新方法,就像让学生既学好数学又学好语文。它解决的核心问题是不同任务之间的相互干扰,通过直接优化AI的内部表征空间,既保护每个任务的独特性,又促进任务间的有益协作,避免了传统方法中"顾此失彼"的问题。

Q2:这个方法会不会很复杂,实际应用中好用吗? A:虽然原理相对复杂,但Rep-MTL在实际使用中表现出良好的稳定性和效率。它对参数调整不太敏感,不需要过度精细的调优就能取得好效果。而且计算效率比很多现有方法都要高,比如比Nash-MTL快26%,这让它在实际应用中更有优势。

Q3:Rep-MTL的效果到底有多好?能用在哪些地方? A:实验显示Rep-MTL在各种任务组合中都取得了最佳性能,比如在室内场景理解任务中性能提升了1.70%,比之前最好的方法高出48%。它可以应用在自动驾驶、智能助手、机器人等需要同时处理多种任务的AI系统中,帮助这些系统更好地协调不同能力。