榨干3000元显卡,跑通千亿级大模型的秘方来了

书接上回,用几块3000 元显卡作为加速主力的一体机,就能跑通 671B 的DeepSeek。

放在个把月前,你敢想象这样的场景么?

正在埋头苦干,希望有更多样化产品交付的一体机厂商们,pick英特尔锐炫™ 显卡 + 至强 ® W 处理器这套组合拳,首要原因就是它的成本确实诱人——基本算是砍掉了一个数量级(下线可以控制在 10 万元以内)。

其次就是这套组合也很能打,上面那个场景就是它目前的 " 标杆式 " 战绩。

这两点加起来就是 " 真香 " 定律的复现。

但别光说不练,这种极具性价比的一体机实测的体感到底如何呢?

带着这个问题,我们直接上手亲自测试了一波。

例如我们先用 QwQ-32B 离线状态下问了个经典题目:

9.9 和 9.11 哪个大?

从效果上来看,若是单人使用,一体机的速度已经达到了32 tokens/s。

讲真,这个速度在体感上已经是非常 OK 了。

而且这还不是个偶然事件,在同样的情况下,我们再问一个问题:

一个外星人来到地球后等可能选择以下四件事中的一件完成:

1,自我毁灭;

2,分裂成两个外星人;

3,分裂成三个外星人;

4,什么都不做。

此后每天,每个外星人均会做一次选择,且彼此之间相互独立。

求地球上最终没有外星人的概率。

同样的,我们可以看到输出速度依旧是非常的快。

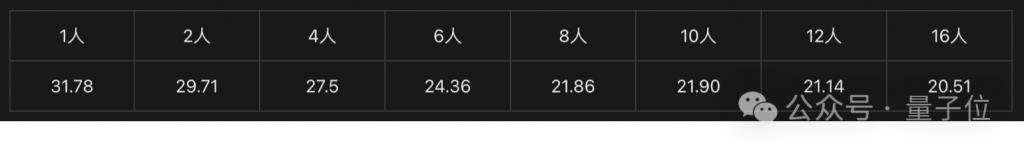

而当同时使用人数增加时,我们做了初步的计算,其每秒 tokens 的速度大概是这样的:

那么如果是地狱难度的671B DeepSeek R1,结果又会如何呢?

毕竟即便是 Q4 量化版本,以往承载它的一体机成本动辄就要达到 200 万元。

请听题:

一个汉字具有左右结构,左边是木,右边是乞。这个字是什么?只需回答这个字即可。

如此大体量的大模型,这种 10 万元级别的一体机依然可以达到 10 tokens/s 的速度。

虽然体感上会觉得稍慢一些,但够用却是真的。

而且有一说一,输出速度够快、时延够低、性价比够高,还只是这种英特尔架构一体机的优点的一隅。

在它的背后,还有易部署、易操作等特点。

那么为何基于英特尔的一体机可以做到如此物美价廉?

价低质优的一体机,是如何炼就的?

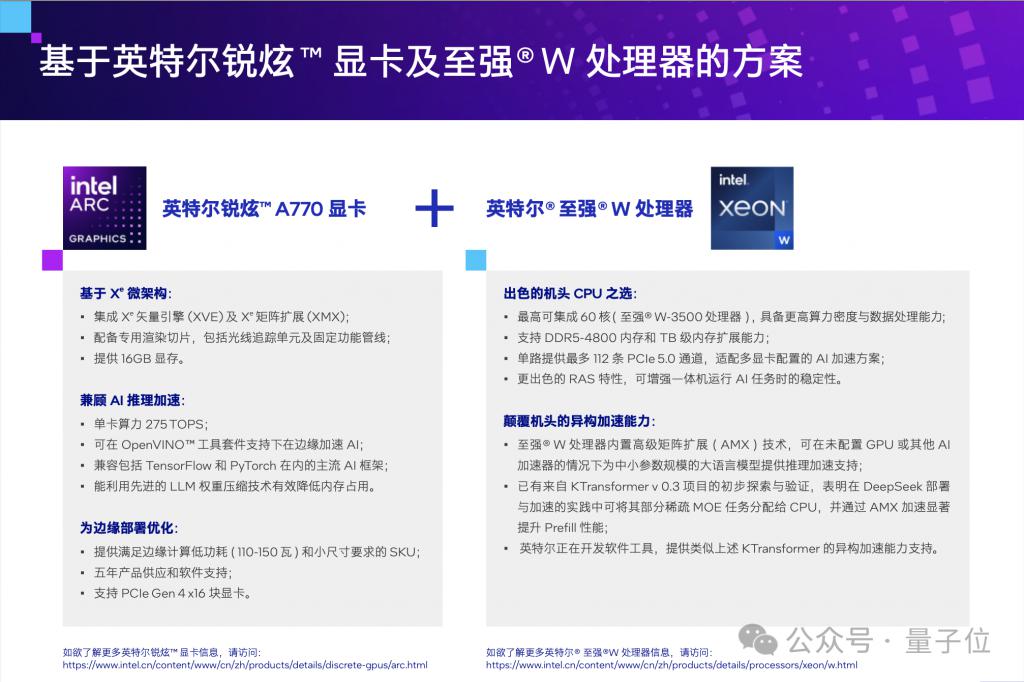

正如我们刚才提到的,10 万级别的一体机能有如此实用质感,其关键就是英特尔的组合拳:

锐炫™ 显卡 + 至强 ® W 处理器。

首先我们来看下这张英特尔锐炫™ 显卡。

它是英特尔专门为 AI 和图形处理打造的高性能显卡,不仅游戏表现亮眼,在 AI 推理、视频处理这些专业领域也很能打。

锐炫™ 显卡采用了最新的 Xe 架构,内置 XMX AI 加速引擎,提供强大的 AI 加速能力,支持 Ollama 和 vLLM serving 等多种大模型主流框架,跑大模型推理可以说是完全没有压力。

而且它还支持 TensorFlow、PyTorch 这些主流 AI 框架,搭配 OpenVINO ™ 工具套件还能进一步优化性能,让 AI 任务跑得更快、更省资源。

锐炫™ 显卡还有一个特点,就是特别适合边缘计算——

锐炫™ 显卡针对边缘计算场景优化,提供低功耗(110-150 瓦)和小尺寸选项,支持 PCIe Gen 4 接口,并为边缘应用场景承诺五年产品供应和软件支持。

也正像刚才展示的那样,比如 DeepSeek、Qwen 这些开源模型,锐炫™显卡能轻松搞定,尤其是支持多卡并联,2 卡、4 卡甚至 8 卡都能配,性能直接起飞。

而且装载它的一体机不仅仅能作为 AI 或大模型一体机来使用,有需求时还能用来执行视频分析、8K 视频编解码、3D 渲染这些高负载任务,一机多用,性价比超高。

除了显卡之外,至强 ® W 处理器,这块适用于工作站和 AI 一体机 " 性能怪兽 "CPU,也是一个关键点。

从算力层面来看,它最高 60 核的配置,搭配 DDR5-4800 内存和 TB 级内存扩展,跑大模型、做数据处理都游刃有余。

它内置的 AMX(高级矩阵扩展)技术,就算没有独立显卡,也能加速中小规模参数的大语言模型推理,性价比也是直接拉满。

至强 ® W 处理器能与锐炫™ 显卡搭档的原因还有它支持多显卡配置,拥有多达 112 条 PCIe Lane,PCIe 5.0 通道管够。

在此之上,英特尔还通过统一的计算架构和优化工具链,让锐炫™ 显卡和至强 ® W 处理器,发挥出了 1+1>2 的效果。例如:

IPEX-LLM

专门为大模型优化,支持 DeepSeek、Qwen、Llama 等主流开源模型,让 CPU+GPU 协同推理更高效。

OpenVINOTM 工具套件

优化 AI 推理,自动分配任务给 CPU 或 GPU,还能压缩模型,减少内存占用,提升速度。

oneAPI

统一编程模型,开发者只需写一次代码,就能同时在 CPU 和 GPU 上运行,不用再为不同硬件适配发愁。

总而言之,英特尔可以说是通过硬件协同 + 软件优化,让 CPU 和 GPU 不再是孤立的计算单元,而是高效配合的 " 黄金搭档 "。

这也就不难理解为什么基于英特尔解决方案的一体机,能够做到如此的价低 + 质优了。

实战:如何在英特尔架构一体机上玩转 DeepSeek

看过 Demo 演示和一体机介绍,你可能会好奇,假如现在就有机会拿到一台这样的一体机,该怎么用它把 DeepSeek 跑起来?

首先要配置系统环境,更新 GPU 驱动版本必不可少。

https://dgpu-docs.intel.com/driver/client/overview.html

主要框架是英特尔 IPEX-LLM 版本的 llama.cpp,

以 Linux 系统为例,IPEX-LLM llama.cpp portable tgz 包

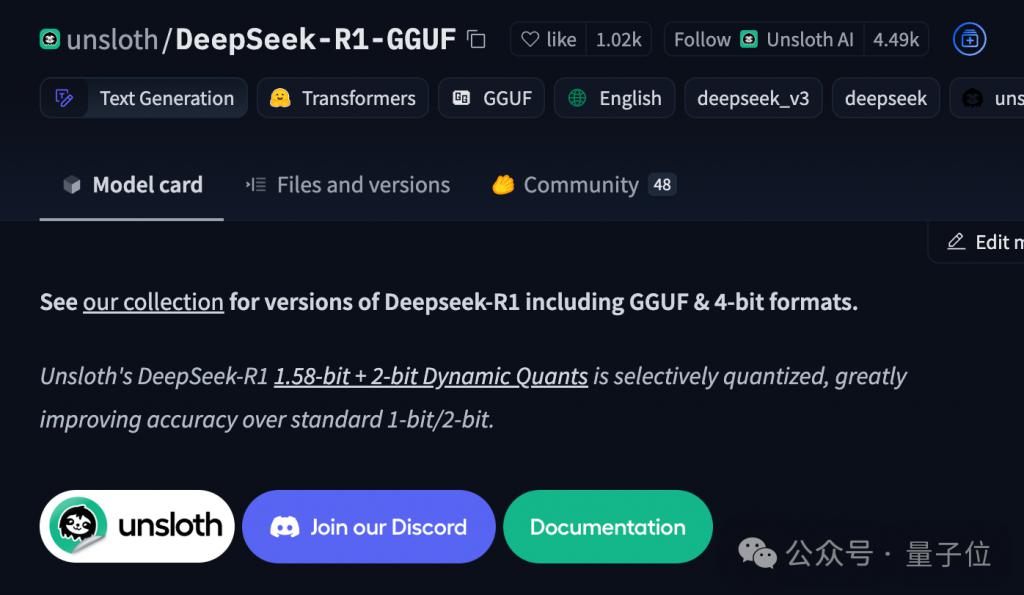

在这个框架中,推荐使用 GGUF 格式的模型,这里使用 unsloth 开源版本来说明。

开启终端后,输入以下命令进入解压缩后的文件夹:

cd /PATH/TO/EXTRACTED/FOLDER

要使用英特尔 GPU 加速,在运行 llama.cpp 之前,需要设置如下环境变量:

export SYCL_CACHE_PERSISTENT=1

接下来,如果要运行的是 671B 版本 DeepSeek-R1,就要请出 FlashMoE 来帮忙了。

DeepSeek-R1 基于 MoE 架构,其实满血版的激活参数仅约 37 亿,但还是需要完整加载整个模型,这也是对于一体机来说最大的难点。

FlashMoE 是一款基于 llama.cpp 构建的命令行工具,专为 MoE 模型进行优化,整合了至强 ® W 处理器内置的 AMX/AVX-512 技术和 GPU 加速库,进一步释放 CPU 与 GPU 的异构协作能力,能在较低的硬件成本下获得更高的推理吞吐量与更优的性能表现。

在 llama.cpp + FlashMoE 组合加持下,初步的性能验证表明,在单路至强 ® W 处理器加 2-4 块英特尔锐炫™ A770 显卡配置下,本文所述方案可以获得接近 10 Token/s 的性能表现,已能满足企业级生成式 AI,例如离线语音助手、文档摘要等应用场景的需求。

总的来说,这套高度集成的软硬一体模式,既满足了长上下文推理需求,又实现了能耗和成本的可控,为 AI 服务规模化落地提供了可靠且易用的基础设施。

同时,它能更好地满足近期用户在 DeepSeek 或其他开源大模型实践中的迫切需求,部署方式更灵活、更贴近业务环境,响应速度更快,还在数据安全和隐私保护方面具有先天优势。

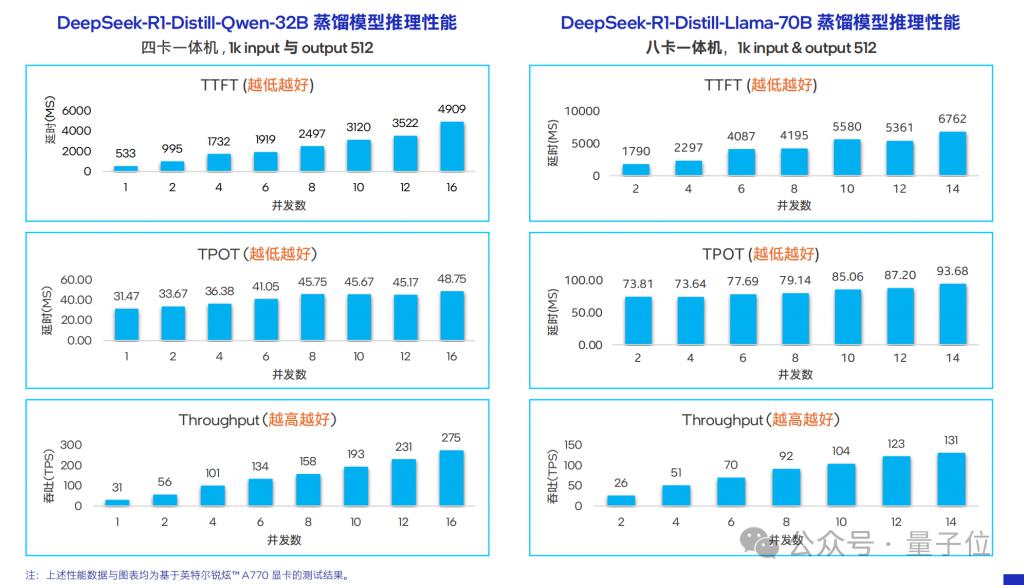

以上是针对 671B 版 DeepSeek 的部署方法简要介绍,但实际上,蒸馏版凭借其精简而高效的特点,能够更好地贴合各行业的实际业务场景和需求。

蒸馏版和满血版的部署指南,都可在英特尔中文官网 ( intel.cn ) 搜索「锐炫一体机」获取。

它在应对这些行业的常规任务时,不仅能够提供足够的处理能力和精准度,还能以更加灵活和易于部署及适配的方式融入到行业的业务流程当中。

" 低成本 + 高效率 " 的路子还在继续

随着 DeepSeek 的影响力不断扩大,大模型发展迎来了新的趋势:走向推理普及化。

在以往,算力大多被集中投入到模型训练中,但在未来,算力资源的分配将发生显著转变,更多的算力会被应用于推理环节而非训练。

△图源:IDC& 浪潮信息

从应用场景和市场选择来看,除了超大规模的数据中心依旧在大模型运算中扮演关键角色外,一体机凭借其独特的优势,正成为越来越多企业的心仪之选。

而在这个趋势之中,一体机的优势就在于 " 低成本 + 高效率 ",具体而言:

首先,一体机启动成本低。与传统分散式设备组合搭建系统相比,其在硬件采购、软件授权和初始配置等方面资金投入少,企业无需花大量前期资金构建完整运作体系,能以较低成本开启业务或办公流程。

同时,一体机易于维护部署。其高度集成化设计优化硬件兼容性,减少硬件不匹配故障。日常维护中,其整体性强,便于技术人员进行故障排查和维修,提高维护效率、降低难度。

此外,一体机可常驻用户办公与业务环境边缘加速操作,在靠近数据源头和使用场景处运行,减少数据传输距离和时间,降低延迟,提升业务处理速度和响应效率。

当然,一体机只是运行模型的硬件基础,从英特尔最近的动作看来,对接和扩展更多接地气的 AI 应用才是下一步重点:

联合 Hugging Face、Anyscale、Zilliz 等 AI 行业合作伙伴推出的企业 AI 开放平台 ( OPEA ) ,就是最好的证明。

如何理解 OPEA?

首先,它提供了搭建大模型应用所需的零件,如提示引擎、数据处理、记忆系统、安全护栏等一起打包提供,解决生成式 AI 技术的工具碎片化问题。

然后,它还是一款评估和优化应用,能够从性能、可信度、可扩展性和弹性等方面对 AI 应用进行 " 体检 "。以电商推荐商品的 AI 应用为例,通过 " 体检 " 可对应用进行针对性的改进,使其更实用。

所以众多合作伙伴加入,共建这个项目也就不奇怪了。

随着越来越多的合作伙伴加入,OPEA 生态将不断发展壮大并衍生出多样化的发展路径。

例如中国开放智能计算产业联盟(COIA)目前已汇聚近 60 家成员单位,专注于推动企业 AI 生态协同发展。该联盟即将推出 "Powered By OPEA" 认证体系,旨在确保合作伙伴间 OPEA 生态的互联互通。

作为业界首个企业级 AI 应用认证标准,该体系将成为 OPEA 生态的核心保障机制,为通过认证的产品授予跨平台互操作性标识。

"Powered By OPEA" 认证将促进 AI 产业生态的完善,加速企业 AI 标准化进程,并最终发展成为企业选择生成式 AI 组件的重要信任基准。

"AI 无处不在 " 的故事正持续上演。

最后,附上量子位完整实测基于英特尔解决方案一体机的视频: