开源即屠榜!UniME多模态框架登顶MMEB全球训练榜,刷新多项SOTA纪录

告别 CLIP 痛点,更懂语义关联的跨模态理解新 SOTA 来了!

格灵深瞳、阿里 ModelScope 团队,以及通义实验室机器智能团队联合发布通用多模态嵌入新框架 UniME,一经推出就刷新 MMEB 训练榜纪录。

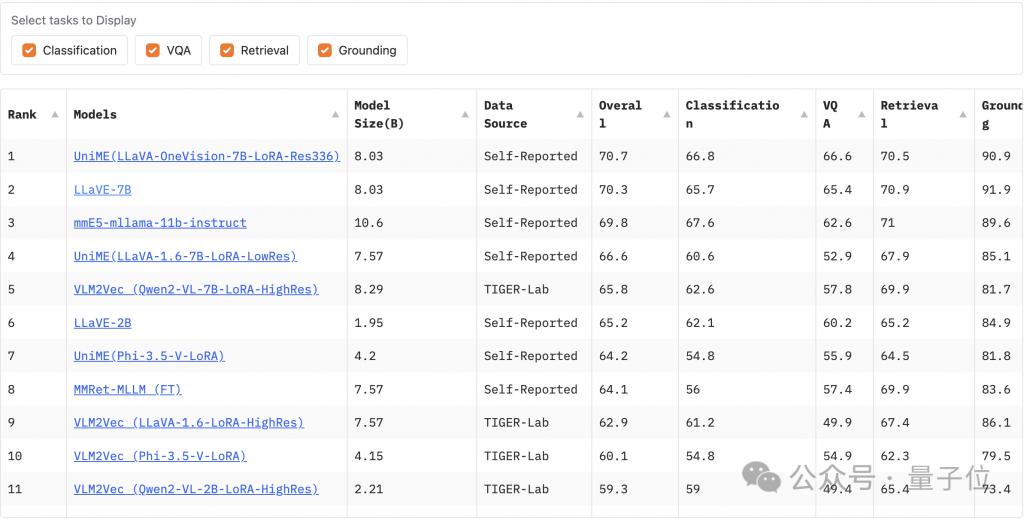

△图片于 2025 年 5 月 6 日 08:00 UTC+8 截取

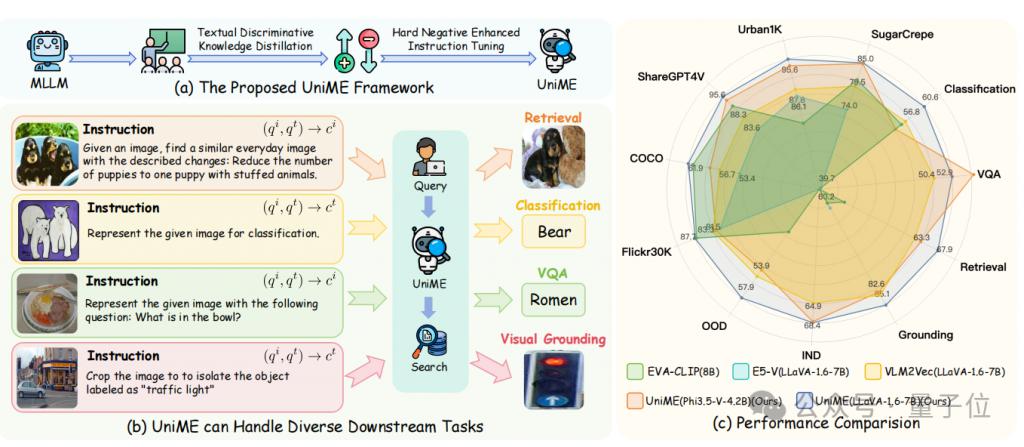

UniME 作为一个创新性的两阶段框架,所展现的卓越的组合理解力,帮助 MLLMs 具备学习适用于各种下游任务的判别性表征的能力,并在多个任务中达到了新的 SOTA。

目前,该项目已开源,可点击文末链接一键获取~

以下是 UniME 的更多相关细节。

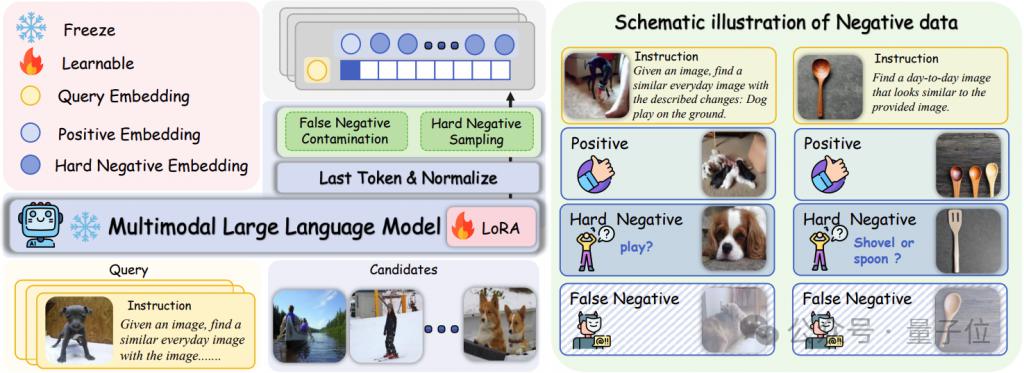

UniME 训练框架拆解第一阶段:文本判别知识蒸馏

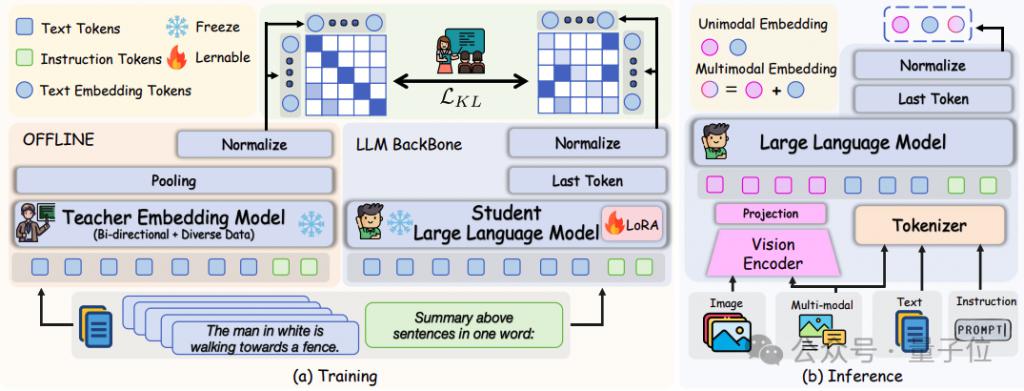

训练

受 E5V 等之前研究的启发,研究团队第一阶段选择使用纯文本数据来增强了 MLLM 中 LLM 语言组件的嵌入能力。

由于 LLM 采用自回归解码器架构,因果掩码机制会从本质上限制了它们的判别能力。

为了解决这一限制,团队引入了如图所示的文本判别知识蒸馏。

△文本判别知识蒸馏阶段的框架

从最先进的基于 LLM 的嵌入模型 NV-Embed V2(该模型在对比训练中移除了因果注意力掩码并使用多个多样化的数据集进行训练)中转移知识。

具体来说,团队首先将 LLM 组件从 MLLM 架构中分离出来,并使用嵌入提示处理仅文本输入:" Summary the above sentences in one word: n"。

然后,从最终令牌的隐藏状态获得规范化的学生文本嵌入和离线提取的教师文本嵌入,其中是批量大小,是嵌入的维度。

随后,通过最小化教师模型和学生模型嵌入之间的 Kullback-Leibler(KL)散度来实施判别性分布对齐 :

其中是用来软化分布表示的温度超参数。

通过在一个批次内不同样本之间的关系蒸馏,该方法在相同数据和训练条件下相较于直接使用对比学习在下游任务中展示出显著的性能提升。

推理

在训练阶段,此方法仅使用纯文本输入,并单独优化多模态语言模型架构中的语言模型组件,同时保持其他参数不变。

在推理时,恢复原始的视觉编码器和投影层,以启用多模态处理。

对于单模态输入(文本或图像),使用特定于模态的标准化提示。

对于图文交错的输入,独立处理每种模态及其相应的提示,并通过元素级求和聚合嵌入从而得到最终的多模态表示。

第二阶段:困难负样本增强指令微调

在完成文本判别知识蒸馏截断的训练后,UniME 已经具备了初步的判别能力但表现出较弱的视觉敏感性,这种不敏感导致图文对齐出现偏差,并限制了判别性能。

此外,第一阶段使用的通用指令提示限制了 UniME 在复杂检索任务中的效果。

为了解决这些限制,研究人员引入了一个额外的困难负例增强指令调整阶段,该阶段目的在于:

1. 进一步增强模型判别能力。

2. 改善模型跨模态对齐。

3. 加强下游任务中的指令跟随能力。

△困难负样本增强指令微调阶段的框架

错误负样本污染

训练批次中错误负样本的存在妨碍了在标准 InfoNCE 损失下有效区分困难负样本。

为了缓解这一问题,团队引入了一个基于 Query 和正样本相似度阈值的过滤机制,定义为:,其中是用来控制阈值边界的超参数。

在训练期间,排除所有与 Query 相似度超过的负样本来过滤错误负样本同时保留具有挑战性的困难负样本。

困难负样本采样

困难负样本在标签上与正样本不同但在向量空间中非常接近,这类具有挑战性的样本能够在对比学习过程中显著增强模型的判别能力。

相比之下,简单负样本产生的梯度微不足道,对学习过程的贡献极小。

因此团队提出一种困难负样本采样策略,旨在优化训练效率和判别性能。

由于文本判别知识蒸馏阶段之后 UniME 已经具备了初步的判别能力,在此能力基础上,研究人员在每个训练批次中抽样个对应的困难负样本,如下所示:

其中和分别表示经过筛选的错误负样本候选和正样本候选,是查询嵌入,表示所有候选嵌入,函数计算成对相似度得分,选择得分最高的前个候选作为困难负例。

训练目标

在获取了查询的嵌入()、正样本候选()和困难负样本候选()后,我们使用噪声对比估计(InfoNCE)损失对批次内采样的困难负样本进行如下处理:

其中表示所有困难负例的集合,是一个温度超参数。

训练食谱

第一阶段:文本判别知识蒸馏

团队采用 QLoRA 对大型语言模型组件进行参数高效的微调。

这一阶段仅使用纯文本输入并仅训练极少的参数(通常不超过总数的 5%),完整训练 Phi3.5-V 和 LLaVA-1.6 分别需要大约 1 小时和 2 小时。

第二阶段:困难负样本增强指令微调

为了克服较大批量 MLLM 训练时的 GPU 内存限制,研究人员采用了两种策略:

参照 VLM2Vec,使用了 GradCache 梯度缓存技术将对比损失计算和编码器更新的反向传播分离;

采用 QLoRA 对 MLLM 内所有参数进行参数高效的微调。

将这两种策略进行组合有效地促进了训练效率同时显著降低训练时的内存开销。

实战性能全验证训练数据

研究人员在第一阶段的文本判别知识蒸馏中使用了 Natural Language Inference ( NLI ) 数据集,该数据集包含约 273k 个句子对。

对于困难负例增强指令调优阶段,使用了 MMEB 基准提供的训练数据集,涵盖了四个核心多模态任务:分类、视觉问答、多模态检索和视觉定位。

这一全面的训练语料库,结合了单模态和多模态输入数据,共计 662k 经过精心策划的训练对,确保了模型在多样化的多模态任务中的稳健适应。

下游评测

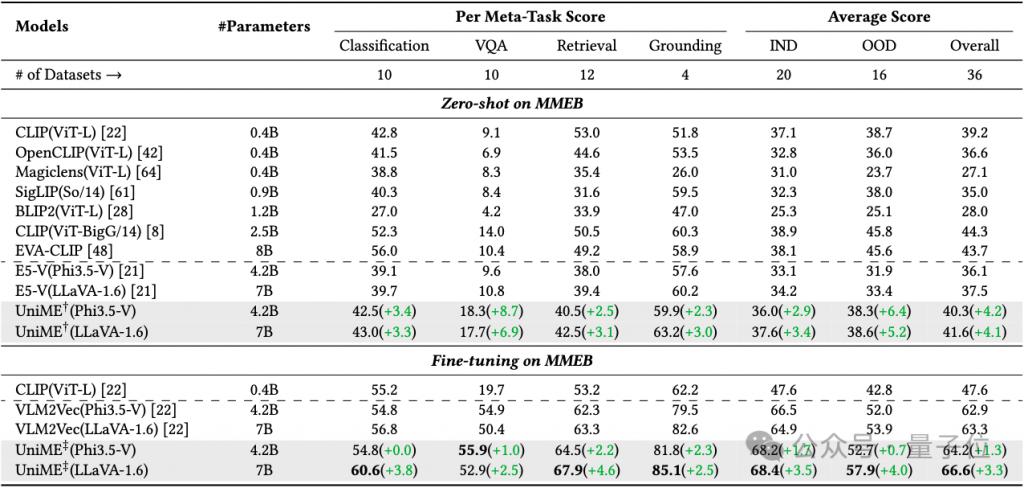

团队评估了 MMEB 中的分布内(20 个测试集)和分布外(16 个测试集)基准,以评估 UniME 在多样化检索任务中的多模态嵌入能力。

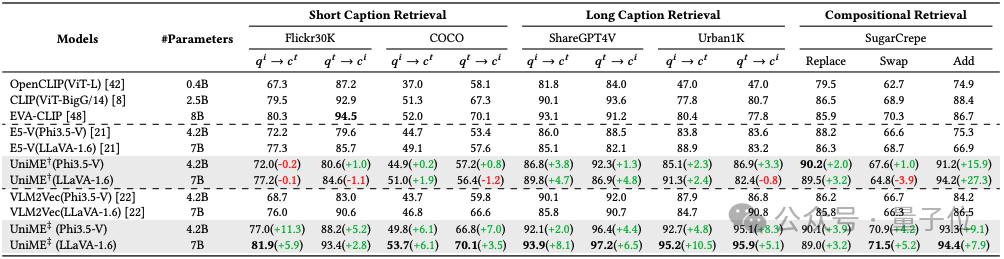

为了进一步检验 UniME 的单模态嵌入性能,研究人员在多个跨模态检索任务上进行了实验,包括短标题图文检索(Flickr30K 和 COCO2014),长标题图文检索(ShareGPT4V 和 Urban1K),以及组合式检索(SugarCrepe)。

实验结果

多模态检索

在表 1 中,展示了 UniME 与现有基线模型的性能对比,其中 IND 代表分布内数据集,OOD 代表分布外数据集,报告的分数是相应数据集上平均精确度,最佳结果用粗体标出,†表示仅文本判别蒸馏的 UniME,‡表示文本判别蒸馏和困难负样本增强指令调优的 UniME。

△表 1:MMEB 基准测试结果

在相同的训练数据和配置设置下,UniME 相比 E5-V 在不同的基础模型上始终展示出显著的性能提升。

使用 Phi3.5-V 模型时,UniME 的平均性能提高了 4.2%;采用 LLaVA-1.6 作为基础模型时,UniME 的平均性能进一步提高了 4.1%。

这些显著的性能提升主要归功于团队提出的文本判别知识蒸馏方法可以更有效地增强 MLLM 中 LLM 语言组件的判别能力。

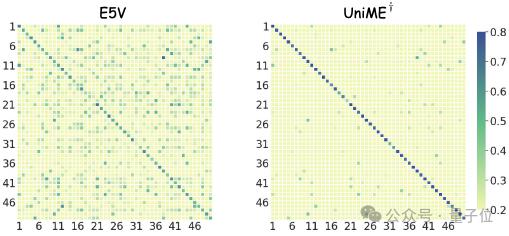

如图所示,团队随机从 COCO 中选择 50 个样本,并可视化跨模态余弦相似度矩阵。

与 E5-V 相比,UniME 矩阵的对角线清晰度显著增强,表明 UniME 学习到了更具判别性的表征。

在困难负样本增强指令微调之后,UniME 的嵌入判别能力进一步提高。

与 VLM2Vec 相比,UniME 在 Phi3.5-V 和 LLaVA-1.6 基础模型上分别实现了 1.3% 和 10.3% 的性能提升。

短 - 长标题跨模态检索

如表 2 所示,团队在零样本跨模态检索任务上评估了 UniME。

△表 2:零样本文本 - 图像检索的结果

首先,在短标题数据集 Flickr30K 和 MSCOCO 上进行实验。

在文本判别知识蒸馏阶段之后,UniME 的检索性能与 E5-V 相当。

随后的困难负例增强指令调优进一步提升了 UniME 的表现,相较于 VLM2Vec 提高了 5.2%-11.3%。

对于在 ShareGPT4V 和 Urban1K 数据集上的长标题检索任务,UniME 在所有指标上均表现出优越性能。

在文本判别蒸馏阶段后,基于 Phi3.5-V 模型 UniME 展示了 1.3%-3.8% 的性能提升。

随后通过困难负例增强指令调优的进一步增强,UniME 相较于 VLM2Vec 提高了 2.0%-8.3%。

值得注意的是,与 EVA-CLIP ( 8B ) 相比,UniME 在 Urban1K 数据集上的长标题检索中,性能提升了 14.8% 和 18.1%。

这一显著增强主要源于 EVA-CLIP ( 8B ) 受 77 文本输入令牌长度的限制,从而严重阻碍了其传达长标题完整语义信息的能力。

跨模态组合检索

团队在组合理解基准 SugarCrepe 上评估了 UniME 模型区分困难负样本的能力。

如表 2 所示,UniME 在所有评估指标上均展示出最佳结果。

在文本判别知识蒸馏后,基于 Phi3.5-V 的 UniME 在关系替换、对象交换和属性添加任务中分别比 E5-V 表现出 2.0%、1.0% 和 15.9% 的性能提升。

在第二阶段困难负例增强指令微调后,UniME 的组合理解能力得到进一步增强,与 VLM2Vec 相比分别实现了 3.9%、4.2% 和 9.1% 的性能提升。

此外,与 EVA-CLIP ( 8B ) 相比,UniME 在这些任务上也显示出了 4.2%、0.6% 和 6.6% 的提升,凸显了其在区分困难负例方面的强大能力。

消融实验

困难负样本分析

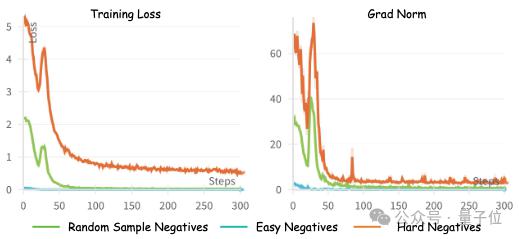

在下图中,展示了三种类型负样本的训练损失和裁剪前梯度范数:简单负样本(批次中最不相似的样本),随机负样本(批次中随机采样的负样本),以及困难负样本(在移除正例和假负例后批次中最相似的负样本)。

由于就简单负样本容易区分,模型通过学习这类数据很难增强其判别能力,因此训练损失迅速收敛到接近零。

使用随机负样本,训练损失比简单负样本收敛更慢,但最终接近零。

相比之下,困难负样本带来更大的挑战,使得训练损失始终保持在较高水平。

相应地,简单负样本的梯度范数最小,而困难负样本的梯度范数明显更高,相差数个数量级。

训练阶段的消融

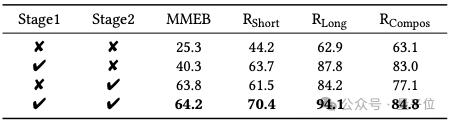

团队基于 Phi3.5-V 来对不同训练阶段进行了消融研究。

△表 3:不同训练阶段的消融研究

如表 3 所示,Phi3.5-V 的初始嵌入判别能力很弱。

在经过文本判别知识蒸馏后,模型在 MMEB 基准、短长标题跨模态检索和组合检索任务上分别获得了 15%、19.5%、24.9%和 19.9%的性能提升。

如果仅进行第二阶段负样本增强指令微调,同一任务的性能提升分别为 38.5%、17.3%、21.3%和 14.0%。

值得注意的是,第二阶段在 MMEB 基准的性能提升明显超过第一阶段,主要是由于模型在遵循下游任务复杂指令方面的能力得到了改善。

通过整合两个训练阶段,UniME 模型在所有评估的下游任务中实现了最佳性能。

输出分布的可视化

为了进一步探索 UniME 嵌入捕获的语义表达,使用此提示 "

团队观察到,在训练之前,预测的词汇更抽象,如 "Pastoral" 和 "Peaceful"。

经过文本判别知识蒸馏后,词汇转向更具体的语义,包括 "cow"、"waterfront" 和 "house",尽管概率分布仍主要集中在 "Farm"。

在第二阶段困难负样本增强指令微调后,概率分布在与图像语义一致的多个词汇上变得更加均匀,从而使嵌入能够更准确地表达图像的语义内容,并增强其判别能力。

论文链接:https://arxiv.org/pdf/2504.17432

代码链接:https://github.com/deepglint/UniME

项目链接:https://garygutc.github.io/UniME

模型链接:https://huggingface.co/DeepGlint-AI/UniME-LLaVA-OneVision-7B

魔搭社区:https://www.modelscope.cn/models/deepglint/UniME

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

点亮星标

科技前沿进展每日见